Étude de cas

Le challenge

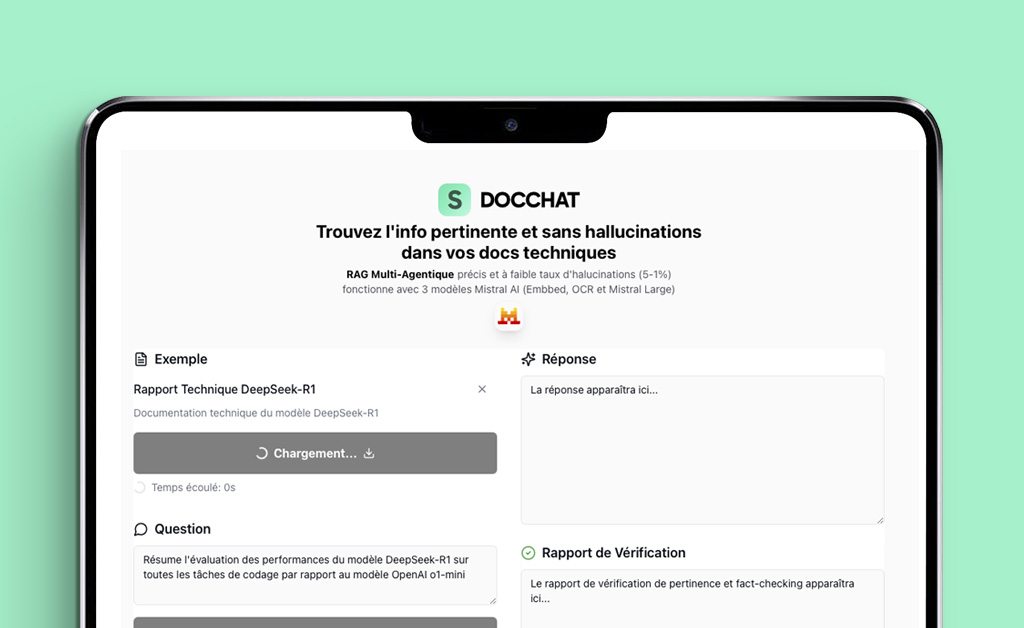

Créer un système RAG récupérant de l'info factcheckée et pertinente dans le cas de docs techniques.

- Pertinence de la récupération : Remonter les passages exacts malgré le bruit, le vocabulaire technique et les tableaux.

- Avoir aussi un factcheck des réponses : Éviter les hallucinations et ne répondre qu'avec des preuves dans le contexte.

- Pouvoir couvrir de multiples documents et pages : Croiser plusieurs sources sans perdre l'information clé.

- Vérifier la qualité OCR avec la solution Mistral OCR : Extraire du texte propre depuis des PDF longs et hétérogènes.

- Évaluer la pertinence : Prouver la pertinence avec des métriques et des comparaisons avant/après.

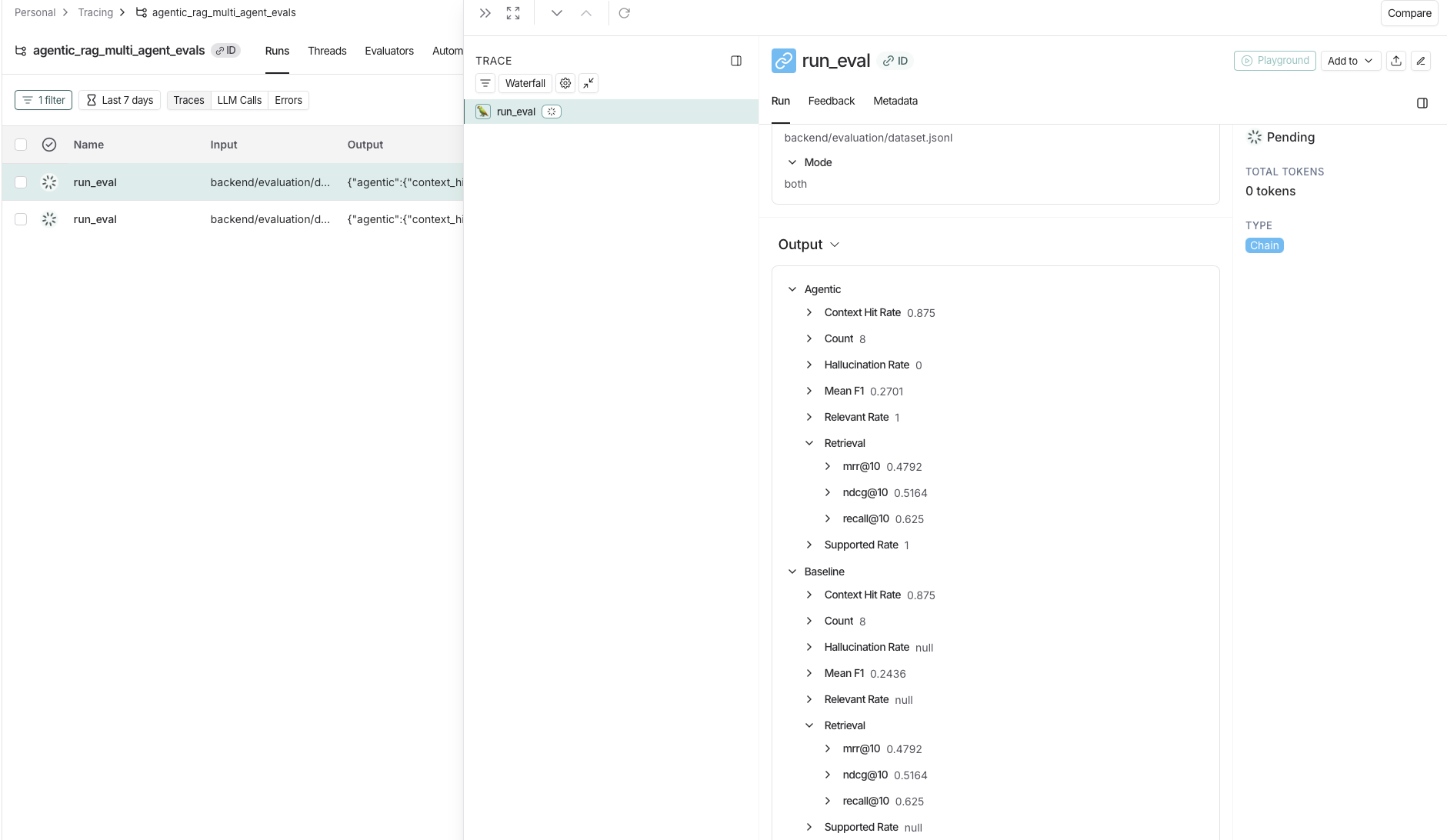

Résultats et évaluation

- Récupération hybride + ajout de 2 agents spécialisés (FactChecker et PertinenceChecker) : La combinaison BM25 + recherche vectorielle permettant la bonne couverture et pertinence des réponses sur des documentations techniques.

- 🎯 Recall@10 (top 10 résultats) : 37.5% → 62.5% — donc 5 questions sur 8 ont au moins un passage pertinent dans le top 10.

- 🎯 MRR@10 (top 10 résultats) : 27.6% → 47.92% — donc en moyenne le 1er bon passage arrive vers la 2ᵉ place.

- 🎯 nDCG@10 (top 10 résultats) : 35.96% → 51.64% — donc classement global de pertience correct, mais pas encore excellent.

- 🌀 Un 0% d'hallucination grâce au reranker développé mais peu fiable, il faudrait des tests sur une plus vaste quantité de données.

- 💡 Au final 81% des résponses jugées pertinentes d'après RAGAS, mais testé sur seulement 2 documents.

Montoring dans Langsmith

En somme un bon POC.

Mais à améliorer pour passage à l'échelle.

Prendre contact

On discute ?

Remplissez le formulaire ci-dessous et je vous recontacte dans les 24-48 heures.